2025年12月、GoogleはAIの「長期記憶」という長年の課題に終止符を打つ可能性を秘めた、新たなアーキテクチャ「Titans」と理論的フレームワーク「MIRAS」を発表しました。これは、現在のAI技術の根幹をなす「Transformer」モデルが抱える限界を克服し、AIが人間のように文脈を理解し、膨大な情報を記憶し続ける未来への大きな一歩となるかもしれません。

本記事では、この革新的な技術がなぜ今注目されているのか、その背景にある課題から、TitansとMIRASが持つ驚くべき仕組み、そして私たちの未来にどのような影響を与えるのかまで、専門的な内容を分かりやすく、そして深く掘り下げて解説します。

1.なぜAIは「忘れっぽい」のか? Transformerモデルが抱える根本的な課題

今日の多くの大規模言語モデル(LLM)は、2017年にGoogleが発表した「Transformer」というアーキテクチャを基盤としています。Transformerは、「Attention(注意)」メカニズムによって、文章中の単語の関連性を捉える画期的な仕組みを取り入れ、自然言語処理の精度を飛躍的に向上させました。

しかし、この強力なモデルにも弱点があります。それは、処理する情報の量(コンテキスト長)が長くなるほど、計算コストが爆発的に増加するという問題です。具体的には、計算量がコンテキスト長の二乗に比例して増大するため、数万ページに及ぶような長大な文書の読解や、ゲノム解析のような膨大なデータ処理には向いていませんでした。この「忘れっぽさ」こそが、AIが真に人間のような思考を手に入れる上での大きな壁となっていたのです。

この課題を解決するため、研究者たちはリカレントニューラルネットワーク(RNN)や、Mambaのような状態空間モデル(SSM)など、様々なアプローチを模索してきましたが、いずれもコンテキストを固定サイズに圧縮する過程で重要な情報が失われるというジレンマを抱えていました。

2.「驚き」を記憶する新発想。Google「Titans」の核心に迫る

そこで登場したのが、Googleの新しいアーキテクチャ「Titans」です。Titansは、従来のモデルとは全く異なるアプローチで、AIに長期記憶能力を与えようとします。その核心は、2つの画期的なアイデアにあります。

2-1. ディープニューラルネットワークで記憶を「学習」する

従来のRNNが固定サイズのベクトルや行列で情報を保持していたのに対し、Titansはディープニューラルネットワーク(多層パーセプトロン)そのものを長期記憶モジュールとして利用します。これにより、単に情報を記録するだけでなく、情報の中から重要な関係性や概念的なテーマを「学習」し、文脈を失うことなく大量の情報を効率的に要約することが可能になります。もはやAIはメモを取るのではなく、物語全体を理解し、統合することができるのです。

2-2. 「サプライズメトリック」で重要な情報だけを選別

Titansのもう一つのユニークな特徴は、「サプライズメトリック」と呼ばれる仕組みです。これは、人間の記憶の仕組みから着想を得ています。私たちは、日常的な出来事はすぐに忘れてしまいますが、予期せぬ「驚き」や感情を揺さぶる出来事は鮮明に記憶します。

Titansは、この仕組みを模倣し、これまでの入力情報から予測できない「驚き」の度合いが高い情報を優先的に長期記憶に保存します。例えば、金融レポートを読んでいる最中に突然バナナの画像が現れたら、それは「高サプライズ」な情報として記憶されます。これにより、AIは膨大な情報の中から本当に重要なものだけを選び出し、効率的に記憶を構築していくのです。

3.すべてのAIモデルを統合する? 理論フレームワーク「MIRAS」

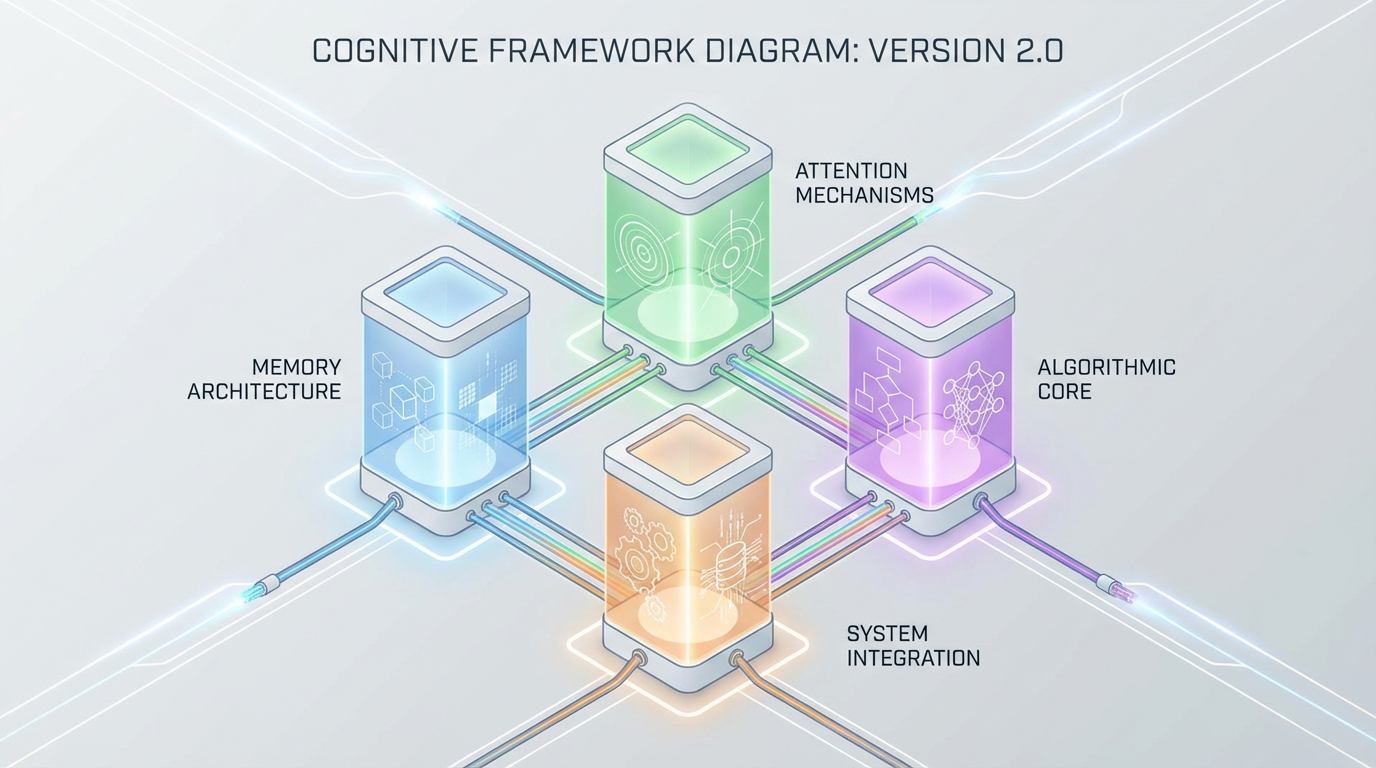

Titansが具体的な「道具」だとすれば、それを支える「設計図」にあたるのが「MIRAS」フレームワークです。MIRASは、シーケンスモデリングにおける様々なアプローチを、実は「連想メモリ」という一つの共通の仕組みで捉え直す、統一的な理論的枠組みです。

MIRASは、以下の4つの主要な設計要素を通じて、あらゆるシーケンスモデルを定義できると提唱しています。

設計要素説明メモリアーキテクチャ情報を格納する構造(例:ベクトル、行列、ニューラルネットワーク)注意バイアスモデルが何を優先的に学習するかの内部目標保持ゲート新しい学習と過去の知識のバランスを取る「忘却」の仕組みメモリアルゴリズムメモリを更新するための最適化アルゴリズム

このフレームワークの強力な点は、従来のモデルが依存してきた平均二乗誤差(MSE)といった単一の指標から脱却し、より多様で堅牢なモデル設計を可能にすることです。実際にGoogleは、MIRASを用いて、外れ値に強い「YAAD」、より安定した長期記憶を持つ「MONETA」、そして最高のメモリ安定性を目指した「MEMORA」といった、特性の異なる新しいモデルを既に生み出しています。

4.Transformerを超えた? Titansの驚異的な性能

では、Titansは実際にどれほどの性能を持つのでしょうか。Googleの研究チームは、TitansとMIRASから生まれたモデルを、Transformer++やMamba-2といった既存の主要アーキテクチャと比較する厳密なテストを行いました。

その結果は驚くべきものでした。特に、長文読解能力を測る「BABILong」ベンチマークにおいて、Titansは、自身より遥かに巨大なモデルであるGPT-4をも上回る性能を示したのです。さらに、200万トークンを超える、これまで考えられなかったほどの超長文コンテキストを処理できる能力も実証されました。

この成果は、Titansが単にテキスト処理だけでなく、ゲノムモデリングや時系列予測といった、より幅広い分野で応用可能であることを示唆しています。

5.まとめ:AIの「記憶革命」がもたらす未来

Googleが発表した「Titans」と「MIRAS」は、AIが抱える「長期記憶」という根源的な課題に対する、非常に有望な解決策を提示しています。「驚き」を学習し、ニューラルネットワークで記憶を動的に構築するという新しいアプローチは、AIが人間のように文脈を深く理解し、継続的に学習し続ける未来を大きく手繰り寄せるものです。

この技術が発展すれば、AIはもはや単なる情報処理ツールではなく、私たちの創造性や知的探求を補助する真のパートナーとなるでしょう。数年後には、今日私たちが「AI」と呼んでいるものの概念が、根底から覆されているかもしれません。AIの「記憶革命」は、まだ始まったばかりです。

参考文献

- Google. (2025, December 4). Titans + MIRAS: Helping AI have long-term memory. Google Research. https://research.google/blog/titans-miras-helping-ai-have-long-term-memory/

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. In Advances in neural information processing systems (pp. 5998-6008).

- 日本経済新聞. (2025, 7月 23日). Googleが描く「長期記憶型AI」. https://www.chowagiken.co.jp/blog/titans_longterm_memory_ai

- note. (2025, 10月 27日). Transformerを超えるか? Mambaと状態空間モデルが描く次世代LLMの地平線. https://note.com/betaitohuman/n/n693953f1a70a

- GIGAZINE. (2025, 12月 8日). GoogleがAIの長期記憶を支援するアーキテクチャ「Titans」とフレームワーク「MIRAS」を開発. https://gigazine.net/news/20251208-titans-miras-help-ai-long-term-memory/